به گزارش شفقنا، وال استریت ژورنال روز جمعه گزارش دادند که کلود در طول عملیات، نه صرفاً در مراحل مقدماتی، مورد استفاده قرار گرفته است. نقش دقیق این ابزار پیشرفته هنوز مشخص نیست، اگرچه ارتش قبلاً از مدلهای هوش مصنوعی برای تجزیه و تحلیل تصاویر ماهوارهای و اطلاعات استفاده کرده است.

سیاستهای این هوش مصنوعی، صراحتاً استفاده از فناوری آن را برای «تسهیل خشونت، توسعه سلاح یا انجام نظارت» ممنوع میکند. هیچ آمریکایی در این حمله جان خود را از دست نداد، اما دهها سرباز و پرسنل امنیتی ونزوئلایی و کوبایی در سوم ژانویه کشته شدند.

سخنگوی شرکت آنتروپیک به آکسیوس گفت: ما نمیتوانیم در مورد اینکه آیا کلود یا هر مدل هوش مصنوعی دیگری برای عملیات خاصی، چه طبقهبندیشده و چه غیره، استفاده شده است یا خیر، اظهار نظر کنیم.

«هرگونه استفاده از کلود – چه در بخش خصوصی و چه در سطح دولتی – مستلزم رعایت سیاستهای ماست.»

رقبای آنتروپیک، اوپناِیآی، گوگل و ایکساِیآی، همگی قراردادهایی دارند که به پنتاگون اجازه دسترسی به مدلهایشان را میدهد—بدون بسیاری از ضمانتهایی که برای کاربران عادی اعمال میشود. اما فقط کلود، از طریق همکاری با پالانتیر تکنولوژیز، در پلتفرمهای طبقهبندیشدهای که برای حساسترین کارهای ارتش آمریکا استفاده میشوند، به کار گرفته شده است.

این افشاگری در لحظهای ناخوشایند برای این کمپانی رخ میدهد؛ شرکتی که هفتههای اخیر را صرف تأکید عمومی بر تعهد خود به «حفاظتهای هوش مصنوعی» و تثبیت جایگاه خود به عنوان جایگزین آگاه به ایمنی در صنعت هوش مصنوعی کرده است.

داریو آمودی، مدیرعامل این شرکت، بارها در مورد خطرات وجودی ناشی از استفاده بدون محدودیت از هوش مصنوعی هشدار داده است. روز دوشنبه، رئیس تیم تحقیقات پادمانهای شرکت آنتروپیک، مرینانک شارما، با هشداری مرموز مبنی بر اینکه «جهان در خطر است»، ناگهان استعفا داد. چند روز بعد، این شرکت بیست میلیون دلار به یک لابی سیاسی که از مقررات سختگیرانه هوش مصنوعی حمایت میکند، اختصاص داد.

بر اساس گزارشها، شرکت آنتروپیک در حال مذاکره با پنتاگون است تا ببیند آیا محدودیتهای بهکارگیری هوش مصنوعی برای هدفگیری سلاحهای خودکار و نظارت داخلی را کاهش دهد یا خیر. این بنبست، قراردادی به ارزش حداکثر ۲۰۰ میلیون دلار را متوقف کرده است، و پیت هگست، وزیر جنگ، قول داده است که از مدلهایی که «به شما اجازه جنگیدن نمیدهند»، استفاده نکند.

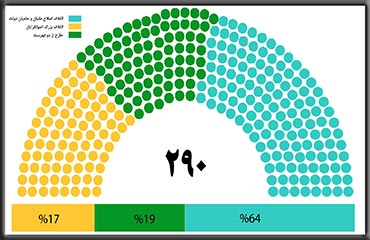

- 17

- 4